在上述示例中,网络有一个单一的标量输入

可视化多变量输出

要将网络扩展到多变量输出

并且两个输出是隐藏单元的两个不同线性函数。

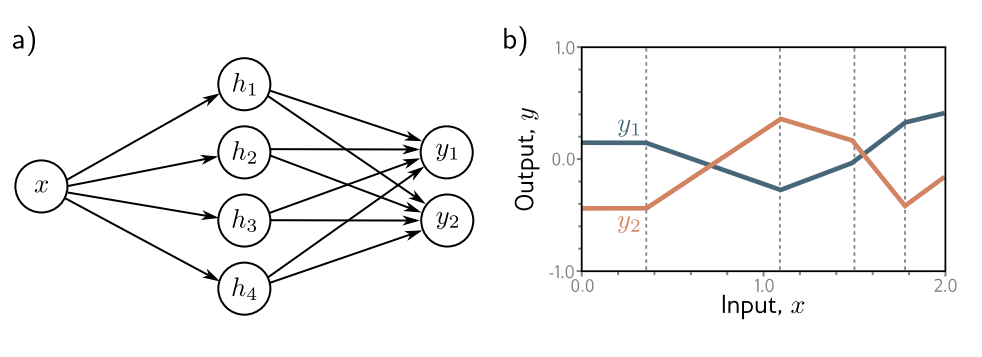

图 3.6 具有一个输入、四个隐藏单元和两个输出的网络。a) 网络结构的可视化。b) 该网络产生两个分段线性函数,y1[x] 和 y2[x]。这些函数的四个“连接点”(在垂直虚线处)由于共享相同的隐藏单元,因此被限制在相同的位置,但斜率和整体高度可能有所不同。

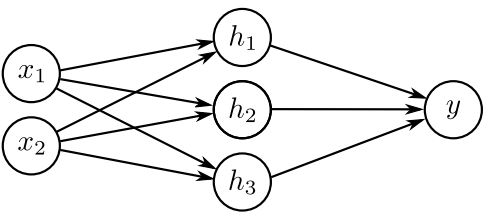

图 3.7 具有二维多变量输入x = [x1, x2]T和标量输出y的神经网络的可视化

正如我们在图3.3中所看到的,分段函数中的“连接点”取决于初始线性函数

可视化多变量输入

为了处理多变量输入

现在每个输入都有一个斜率参数。隐藏单元以通常的方式组合形成输出:

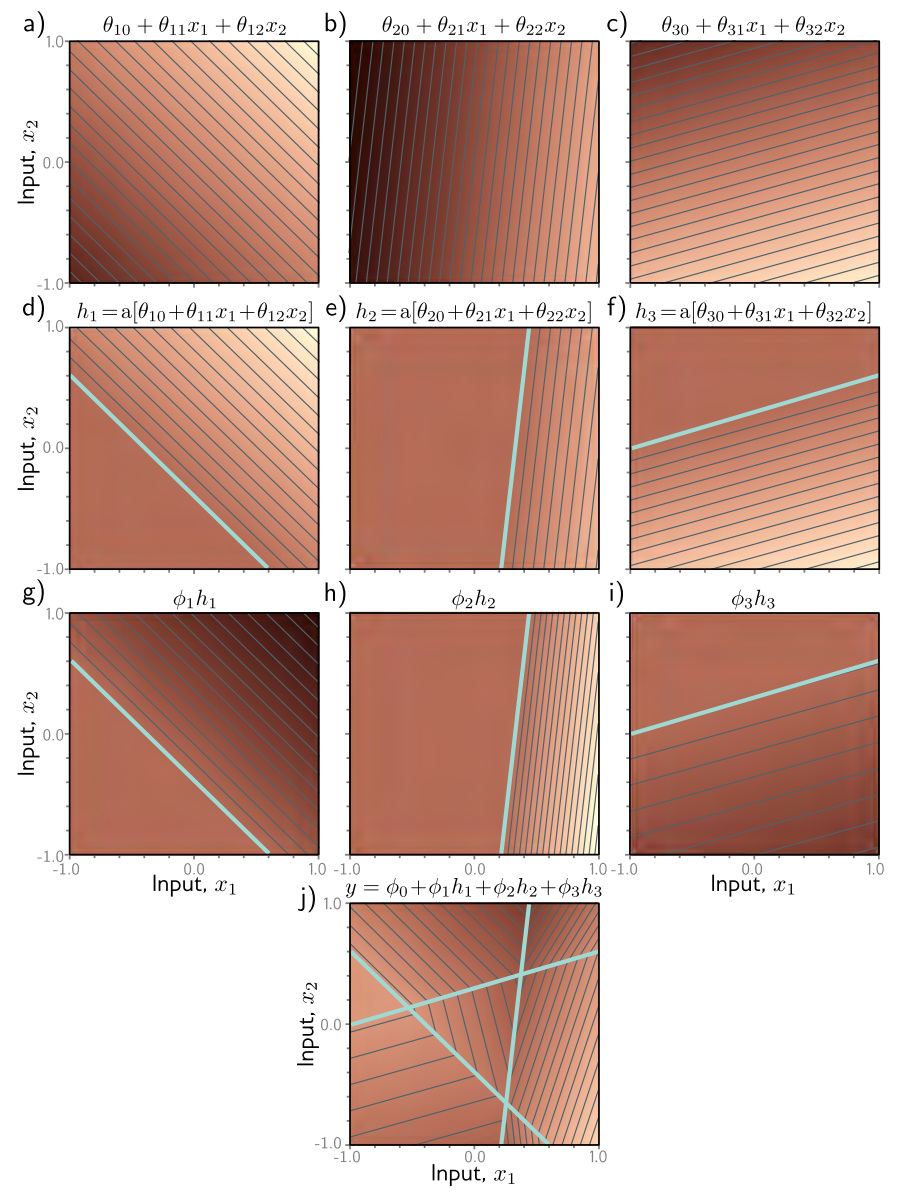

图 3.8 阐述了这个网络的处理过程。每个隐藏单元接收两个输入的线性组合,这在 3D 输入/输出空间中形成了一个定向平面。激活函数将这些平面的负值剪切为零。然后,被剪切的平面在第二个线性函数(方程 3.10)中重新组合,以创建一个由凸多边形区域组成的连续分段线性表面(图 3.8j)。每个区域对应不同的激活模式。例如,在中央三角形区域,第一个和第三个隐藏单元处于活跃状态,第二个则处于不活跃状态。

当模型的输入超过两个时,可视化变得困难。然而,解释是相似的。输出将是输入的连续分段线性函数,其中线性区域现在是多维输入空间中的凸多面体。

请注意,随着输入维度的增加,线性区域的数量迅速增加(图3.9)。为了感受这种增长速度,可以考虑每个隐藏单元定义了一个超平面,该超平面划分了这个单元活跃的空间部分和不活跃的部分(见3.8d-f中的青色线条)。如果我们有与输入维度

图 3.8 在网络中处理两个输入𝐱 = [x₁, x₂]ᵀ,三个隐藏单元h1, h2, h3,和一个输出y。a-c) 每个隐藏单元的输入是两个输入的线性函数,对应于一个有向平面。亮度表示函数输出。例如,在面板(a)中,亮度代表θ₁₀ + θ₁₁x₁ + θ₁₂x₂。细线是等高线。d-f) 每个平面被ReLU激活函数截断(青线等同于图3.3d-f中的“连接点”)。g-i) 截断后的平面随后被加权,j) 并与一个偏移量一起求和,该偏移量决定了表面的整体高度。结果是一个由凸分段线性多边形区域组成的连续表面。交互式演示)